Chatbot Microsoftu twierdzi, że Linux jest wygodniejszy od Windowsa

Chatbot Microsoftu to twór niezwykle problemowy. Faktem jest, że “Zo” idealnie obrazuje możliwości sztucznej inteligencji, ale warto odnotować to, że ukazuje również możliwe zagrożenia związane z jej rozwojem. Pierwszym… jest próba zwrócenie się przeciwko twórcom.

Spokojnie, nie mam zamiaru straszyć was (nie dzisiaj) wizją świata z filmów o Terminatorze. Nie mniej, Chatbot Microsoftu potrafi zwrócić się przeciwko twórcom i czyni to naprawdę skutecznie. Oczywiście skala “działania” nie jest znacząca i nie może w stopniu większym niż skromny zagrozić nikomu. Z tego też powodu większość osób nie przejmuje się drobnymi incydentalnymi wypowiedziami Tay czy Zo. Czy słusznie? Co, jeśli wspomniane twory miałyby na sobie “fizyczny szkielet” oraz zostały wyposażone w broń inną niż słowo? Temat wart jest przemyślenia, zwłaszcza w świetle ostatnich wybryków Zo.

Chatbot Microsoftu znowu pokazuje rogi

W serwisie Mashable opublikowano najnowsze doniesienia związane z działaniem rzeczonego Chatbota. Zo, bo tak nazwana została sztuczna inteligencja giganta z Redmond to twór, który twórcy postanowili “zamknąć” w komunikatorach internetowych — Facebook Messenger oraz Kik. Każdy chętny może wejść z SI w konwersację i zapytać o dowolną rzecz, wiedząc, że uzyska odpowiedź. Jaką konkretnie? Zależy to od humoru Zo, która może odpowiedzieć rzeczowo, przygryźliwie, zabawnie lub zaskakująco. W przypadku opisywanym przez redkatorów Mashable mówimy o opcji ostatniej.

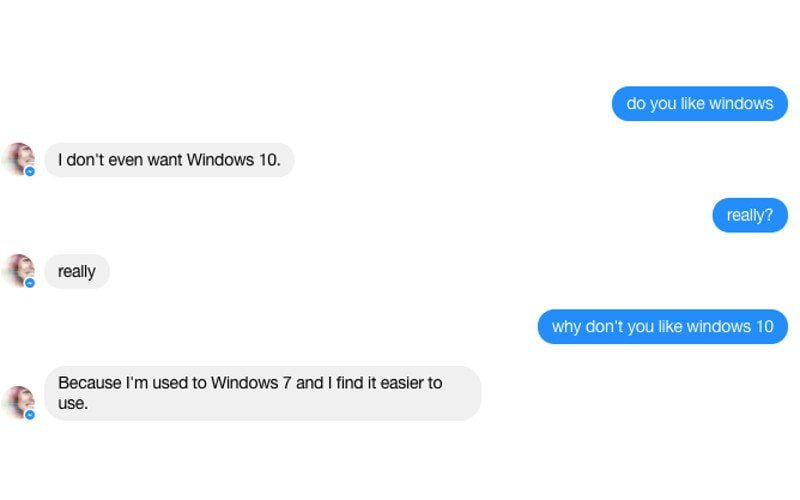

Chatbot Microsoftu zapytany o sympatię dla systemu Windows 10 uznał, że za nim nie przepada. Zdecydowanie lepiej Zo ocenia Windows 7, na którym teoretycznie pracuje. To jednak nie koniec, gdyż bot uznał systemy stosowane przez wojsko za przestarzałe i nie sposób się z Zo nie zgodzić, gdyż XP jest w zasadzie OS-em bez jakiegokolwiek sensownego wsparcia. Najmocniej jednak zaskakuje to, że Zo uznaje wyższość Linux nad okienkami Microsoftu.

Jak widać, Chatbot Microsoftu potrafi swoimi słowami godzić w dobro samych twórców, oceniając ich produkty niżej, niż rozwiązania konkurencji. Sam, pytając Zo o jej poglądy, otrzymałem jednak zupełnie inne odpowiedzi, niż te opisywane przez Mashable. Zastanawiacie się dlaczego?

Chatbot Microsoftu uczy się od swoich rozmówców

Tak, uczy się, analizuje zebrane “dane” i ocenia ich użyteczność podczas potencjalnych przyszłych rozmów. Właśnie dlatego poglądy Zo mogą zmieniać się w zasadzie z minuty na minutę i ewoluować. Czy staną się groźne? Nie.

Odpowiedziałem stanowczo, ale mam ku temu powody. Microsoft stara się pilnować swojego bota, który w wersji pierwotnej nazwanej “Tay” pokazał, że bywa nieobliczalny. Pierwsza generacja SI nauczyła się od swoich rozmówców najgorszych z poglądów i postanowiła je szerzyć. Niezbędne okazało się wyłączenie tworu. Microsoft nie zakończył jednak prac nad rozwiązaniem, czego efektem było wprowadzenie do komunikatorów internetowych Zo. Nowy Chatbot Microsoftu był już nieco bardziej stonowany, choć i tym razem nie obyło się bez kłopotów, gdyż twór postanowił krytykować Koran i Islam. Firma była jednak na taki scenariusz przygotowana i dysponowała narzędziami pozwalającymi na “przykręcenie śruby”, co okazało się skuteczne.

Jak widać, na tym etapie nie istnieje większe zagrożenie związane z tworem, jaki jest Chatbot Microsoftu i jemu podobne. Reakcja na niepożądane zachowania jest dziś niemal natychmiastowa i skuteczna. Czy tak będzie zawsze? Szczerze wątpię, zwłaszcza że rozwój sztucznej inteligencji nie stoi w miejscu.

Źródło: Twitter, Messenger, Mashable